Magma: A Foundation Model for Multimodal AI Agents

디지털과 물리 환경 모두 지배하는 AI 에이전트, 성공률 70%까지 기록

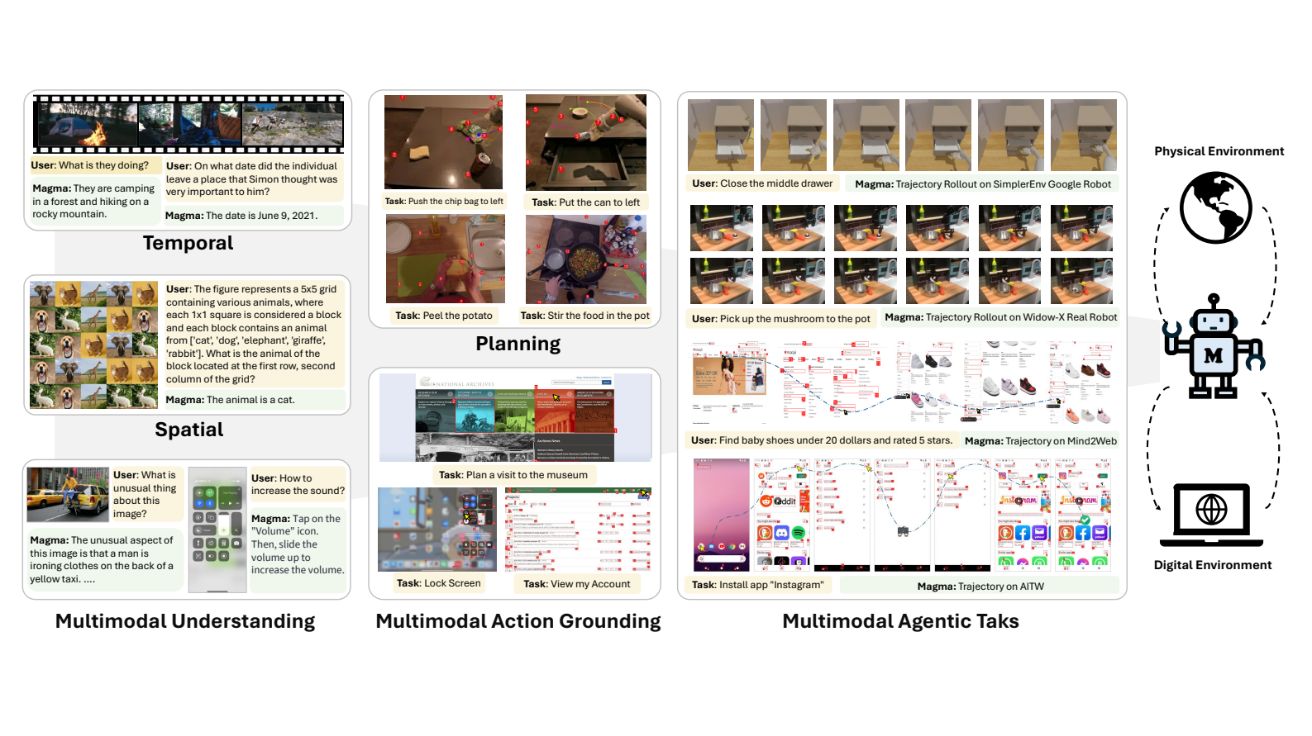

마이크로소프트 리서치 연구팀이 발표한 논문에 따르면, 마그마(Magma)는 디지털 환경과 물리적 환경 모두에서 작업을 수행할 수 있는 최초의 멀티모달 AI 에이전트 기초 모델이다. 기존의 비전-언어(VL) 모델을 확장한 마그마는 단순히 이미지를 해석하는 수준을 넘어서 공간-시간적 지능(spatial-temporal intelligence)을 갖춰 UI 탐색부터 로봇 조작까지 실제 환경에서 다양한 에이전트 작업을 수행할 수 있다. 기존 비전-언어-행동(VLA) 모델들이 디지털 환경과 물리적 환경을 개별적으로 학습해야 했던 한계를 극복하고, 하나의 통합 모델로 다양한 환경에서 강력한 성능을 발휘한다는 점이 마그마의 핵심 혁신이다.

마그마가 가진 가장 주목할 만한 특징은 SoM(Set-of-Mark)과 ToM(Trace-of-Mark) 기법을 통해 행동 이해 및 예측 능력을 향상시켰다는 점이다. SoM 기법은 UI 탐색과 로봇 조작 같은 작업에서 중요한 시각적 객체를 강조하여 모델이 학습하도록 돕는다. 예를 들어 UI 화면에서 클릭 가능한 버튼을 강조 표시하거나, 로봇 조작 시 집을 수 있는 물체를 표시하는 방식이다. 반면 ToM 기법은 시간에 따라 변화하는 객체의 이동 경로를 학습하여 모델이 장기적인 행동 계획을 수립하는 데 기여한다. 이러한 기법들은 마그마가 기존 모델보다 더 정확하게 행동을 계획하고 실행할 수 있게 만들었다.

3,900만 개 데이터셋으로 학습한 통합형 모델의, 경쟁 모델 대비 압도적 성능

마그마 모델의 또 다른 주요 특징은 UI 탐색, 로봇 조작, 인간 행동 비디오, 멀티모달 이해 데이터 등 다양한 유형의 데이터를 하나의 모델에서 통합적으로 학습했다는 점이다. 총 약 3,900만 개의 샘플을 포함하는 이 데이터셋은 마그마가 다양한 환경에서 강력한 일반화 성능을 보이는 데 기여했다.

로봇 조작 데이터로는 Open-X-Embodiment(OXE) 데이터셋을 활용했는데, 이는 22개 이상의 환경에서 수집된 약 970,000개의 로봇 조작 데이터를 포함한다. UI 탐색 데이터는 SeeClick 및 Vision2UI 데이터셋을 활용했으며, SeeClick 데이터셋은 약 850,000개의 UI 화면 데이터를 제공했다. 또한 인간 행동 비디오 데이터는 Epic-Kitchen, Ego4D, Something-Something v2와 같은 대규모 비디오 데이터셋을, 멀티모달 이해 데이터는 ShareGPT4V 및 LLaVA-1.5와 같은 멀티모달 학습 데이터셋을 활용했다.

이러한 이질적인 데이터를 통합 학습하기 위해 ConvNeXt-XXLarge를 비전 인코더로, LLaMA-3-8B를 언어 모델로 사용했다. 특히 모델의 비전 인코더는 고해상도 UI 화면(2000px 이상)도 효과적으로 인코딩할 수 있도록 설계되었으며, 언어 모델은 멀티모달 입력을 기반으로 적절한 행동 명령을 예측할 수 있도록 학습되었다.

UI 탐색 96.3%, 로봇 조작 52.3%...기존 최고 모델 모두 추월

실험 결과, 마그마는 UI 탐색과 로봇 조작 작업에서 기존의 최고 성능(SOTA) 기록을 갱신했다. UI 탐색 성능 측정을 위한 ScreenSpot 벤치마크에서 마그마는 모바일 UI에서 60.4%, 데스크톱 UI에서 75.3%의 정확도를 기록하며 기존 모델들을 능가했다. 또한 VisualWebBench(VWB)에서는 96.3%의 정확도를 기록했다.

로봇 조작 성능에서도 마그마는 Google Robot 환경에서 52.3%, Bridge 시뮬레이터 환경에서는 35.4%의 성공률을 기록하며 기존 OpenVLA(31.7%, 14.5%) 및 Octo(6.0%), RT-1-X(1.1%) 대비 우수한 성능을 보였다. 특히 "서랍에 물체 넣기" 작업에서 OpenVLA 모델이 0%의 성공률을 기록한 반면, 마그마는 43.2%의 성공률을 보였다. 이는 ToM 기법을 활용하여 로봇이 물체를 조작하는 경로를 효과적으로 학습했기 때문으로 분석된다.

실제 환경에서의 성능을 평가하기 위해 WidowX 로봇을 활용한 실험에서도 마그마는 '버섯을 냄비에 넣기' 70%, '핫도그 소시지 이동하기' 67.5%, '천을 왼쪽에서 오른쪽으로 밀기' 25%, '천을 오른쪽에서 왼쪽으로 밀기(제로샷 테스트)' 50%의 성공률을 기록하며 실제 환경에서도 높은 적용 가능성을 보여주었다.

멀티모달 이해 측면에서도 마그마는 VQA 데이터셋에서 81.4%, TextVQA에서 70.2%, ChartQA 및 DocVQA에서는 각각 76.2% 및 84.8%의 정확도를 기록하며 기존 최신 모델들을 능가했다. 이러한 결과는 마그마가 단순히 행동 수행뿐만 아니라 시각적 정보를 이해하고 분석하는 능력도 뛰어나다는 것을 보여준다.

SoM과 ToM 기법 적용으로 '서랍에 물체 넣기' 작업 성공률 43.2% 달성

마그마가 달성한 성과는 향후 멀티모달 AI 에이전트 연구의 새로운 방향을 제시한다. 현재 마그마는 UI 탐색, 로봇 조작, 멀티모달 이해 등에서 강력한 성능을 보이지만, 여전히 몇 가지 한계점이 존재한다. 데이터 편향 문제, 시뮬레이션과 실제 환경 간의 차이, 장기적 행동 계획의 부족 등이 그것이다.

향후 연구 방향으로는 다양한 물리적 환경에서의 테스트 강화, 멀티모달 학습 데이터 확장, 에이전트 협업 및 다중 에이전트 학습, 인공지능의 윤리적 문제 및 안전성 연구 등이 제시되었다. 특히 음성 인식, 3D 환경 인식 등의 추가적인 멀티모달 데이터를 학습하여 모델의 적용 범위를 확장하고, 다중 에이전트 시스템과 결합해 협업 기반 작업을 수행할 수 있는 방향으로 발전할 가능성이 높다.

마그마는 멀티모달 이해와 행동 예측을 동시에 수행할 수 있는 최초의 통합 기초 모델로서, 디지털 및 물리적 환경 모두에서 최고 수준의 성능을 보여줌으로써 AI 에이전트 연구의 새로운 지평을 열었다고 평가할 수 있다.

FAQ

Q: 마그마(Magma)의 가장 큰 차별점은 무엇인가요? A: 마그마의 가장 큰 차별점은 디지털 환경(UI 탐색)과 물리적 환경(로봇 조작)을 하나의 통합 모델에서 모두 처리할 수 있다는 점입니다. 기존의 AI 모델들은 각 환경에 특화된 별도의 모델로 개발되었지만, 마그마는 SoM과 ToM이라는 혁신적인 기법을 통해 다양한 환경에서 모두 뛰어난 성능을 발휘합니다.

Q: 마그마는 실제 환경에서도 잘 작동하나요? A: 네, 마그마는 시뮬레이션 환경뿐만 아니라 실제 로봇 환경(WidowX 로봇)에서도 테스트되어 높은 성공률을 보였습니다. '버섯을 냄비에 넣기'와 같은 작업에서 70%의 성공률을 기록했으며, 심지어 미세 조정 없이 수행된 제로샷 테스트에서도 50%의 성공률을 보였습니다. 이는 마그마가 실제 환경에 적용될 수 있는 가능성이 높다는 것을 보여줍니다.

해당 기사에 인용된 논문 원문은 링크에서 확인할 수 있다.

이미지 출처: 마이크로소프트 리서치

기사는 클로드와 챗GPT-4o를 활용해 작성되었습니다.

AI Matters 뉴스레터 구독하기

![모니터가 그랜저 중고차 값? 1,990만 원짜리 ‘괴물’은 이게 다르다 [이 구역의 미친X]](https://img.danawa.com/images/attachFiles/6/971/5970177_1.jpeg?fitting=Large|320:240&crop=320:240;*,*)

![[작전주 다나와] MSI MAG B860M 박격포 WIFI 메인보드는 지금 저점일까?](http://img.danawa.com/new/mdnw/dpg/img/img_n208_2.png) [

[

![[영상] 가성비 전기차의 진수, BYD 돌핀 시승기](https://img.danawa.com/images/attachFiles/6/970/5969696_1.jpg?fitting=Large|320:240&crop=320:240;*,*)

![명절 내내 풍기는 가스 냄새, 아직도 참으세요? 이젠 인덕션으로 바꿔야 합니다 [이젠 바꿨으면 좋겠네]](https://img.danawa.com/images/attachFiles/6/969/5968987_1.jpeg?fitting=Large|320:240&crop=320:240;*,*)

![[EV 트렌드] 16개월 26만km 달린 '샤오미 SU7' 배터리 놀라운 잔존율](https://img.danawa.com/images/attachFiles/6/970/5969941_1.jpg?fitting=Large|320:240&crop=320:240;*,*)