Inference-Time Scaling for Generalist Reward Modeling

대규모 언어 모델의 성능 향상을 위한 보상 모델링

강화학습 기술은 대규모 언어 모델(LLM)의 성능 향상을 위한 후처리 훈련에 널리 사용되고 있다. 딥시크 연구진이 발표한 논문에 따르면, 적절한 학습 방법이 LLM의 추론 능력을 향상시키는 추론 시간 확장성을 가능하게 할 수 있다는 점이 주목받고 있다. 강화학습의 핵심 과제는 검증 가능한 질문이나 인위적 규칙을 넘어 다양한 분야에서 LLM에 정확한 보상 신호를 제공하는 것이다. 연구진은 다양한 쿼리에 대해 더 많은 추론 계산으로 보상 모델링(Reward Modeling, RM)을 개선하는 방법과 적절한 학습 방법을 통해 성능-계산 확장의 효율성을 향상시키는 방법을 연구했다.

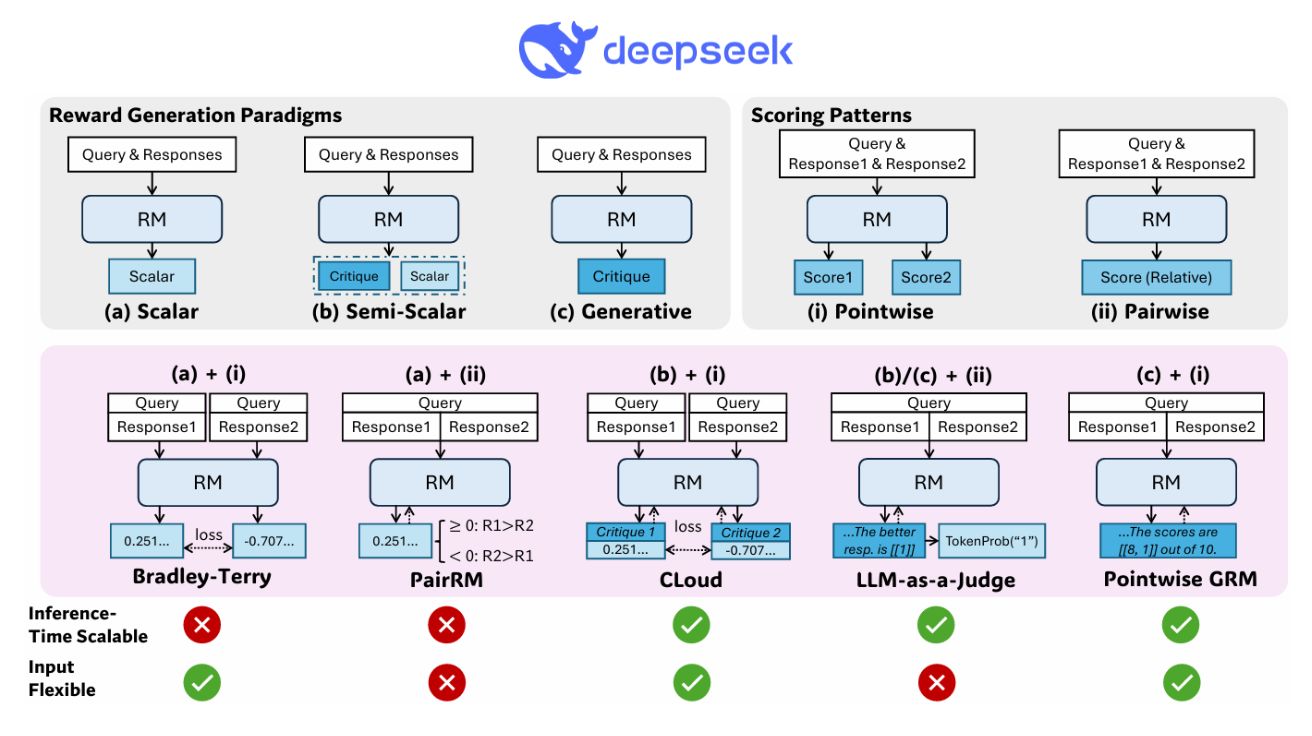

딥시크 연구팀은 RM 접근법으로 서로 다른 입력 유형에 대한 유연성과 추론 시간 확장성의 가능성을 제공하는 포인트와이즈 생성형 보상 모델링(Generative Reward Modeling, GRM)을 채택했다. 학습 방법으로는 자가 원칙 비평 조정(Self-Principled Critique Tuning, SPCT)을 제안해 온라인 강화학습을 통해 GRM에서 확장 가능한 보상 생성 행동을 촉진하여 원칙을 적응적으로 생성하고 비평을 정확하게 만들어 DeepSeek-GRM 모델을 개발했다.

생성형 보상 모델링(GRM): 유연성과 확장성으로 기존 스칼라 모델 한계 극복

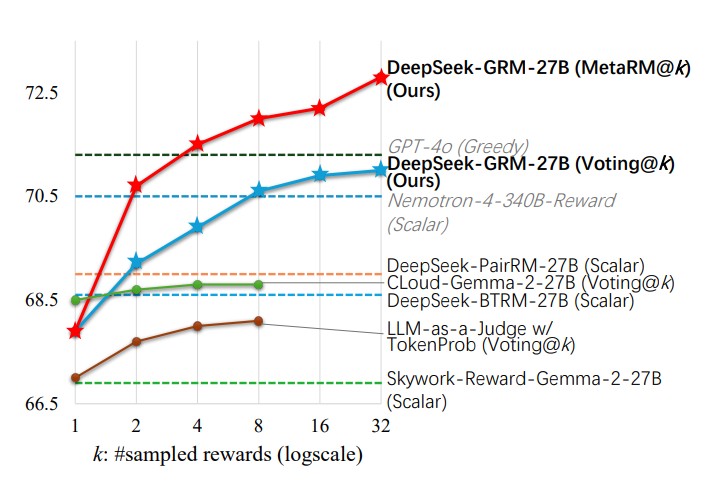

효과적인 추론 시간 확장을 위해 연구팀은 병렬 샘플링을 사용해 컴퓨팅 사용량을 확장하고, 더 나은 확장 성능을 위한 메타 RM(Meta RM)을 도입해 투표 과정을 안내하는 방식을 활용했다. 경험적으로 SPCT가 GRM의 품질과 확장성을 크게 개선하고, 심각한 편향 없이 다양한 RM 벤치마크에서 기존 방법과 모델을 능가하며, 훈련 시간 확장과 비교해 더 나은 성능을 달성할 수 있음을 확인했다.

GRM 모델은 입력 타입에 대한 유연성과 추론 시간 확장성에 특별한 장점을 제공한다. 스칼라 RM과 달리 GRM은 같은 응답에 대해 다양한 보상 신호를 생성할 수 있어 샘플링 기반 추론 시간 확장 방법을 통해 더 나은 보상을 얻을 수 있다. 연구진이 개발한 DeepSeek-GRM-27B는 Gemma-2-27B를 기반으로 SPCT로 후처리 훈련된 모델이다.

자가 원칙 비평 조정(SPCT): 거부형 파인 튜닝과 강화학습의 혁신적 결합

SPCT는 거부형 파인 튜닝(Rejective Fine-Tuning)과 규칙 기반 온라인 강화학습의 두 단계로 구성된다. 거부형 파인 튜닝은 콜드 스타트 역할을 하며, GRM이 다양한 입력 유형에 대해 올바른 형식의 원칙과 비평을 생성하도록 적응시킨다. 기존 연구와 달리, 연구진은 포인트와이즈 GRM을 채택해 동일한 형식으로 모든 응답 수에 대한 보상을 유연하게 생성할 수 있도록 했다.

데이터 구성을 위해 일반 지시 데이터 외에도 사전 훈련된 GRM을 사용해 RM 데이터의 쿼리와 해당 쿼리에 대한 응답에 대한 궤적을 샘플링했다. 거부 전략은 통합되어, 예측된 보상이 실제와 일치하지 않는 궤적(부정확)과 모든 궤적이 정확한 쿼리 및 응답(너무 쉬운 것)을 거부한다. 연구팀은 많은 RM 과제에서 사전 훈련된 GRM이 제한된 샘플링 할당량 내에서 올바른 보상을 거의 생성할 수 없다는 점을 발견했다.

병렬 샘플링과 메타 RM: 최대 32배 샘플로 4.9% 성능 향상 달성

추론 시간 확장을 위해 DeepSeek-GRM은 병렬 샘플링을 사용한다. 병렬 샘플링을 통해 DeepSeek-GRM은 서로 다른 원칙 세트와 그에 따른 비평을 생성한 다음 최종 보상에 투표할 수 있다. 더 큰 규모의 샘플링을 통해 DeepSeek-GRM은 다양성이 높은 원칙에 따라 더 정확하게 판단하고 더 세분화된 세밀도로 보상을 출력할 수 있게 된다.

연구진은 투표 과정을 위한 메타 RM을 훈련하여 확장 성능을 더욱 향상시켰다. 메타 RM은 포인트와이즈 스칼라 RM으로, DeepSeek-GRM에서 생성한 원칙과 비평의 정확성을 식별하도록 훈련되었다. 이 가이드 투표는 낮은 품질의 샘플을 필터링하여 최종 결과의 정확도를 높인다.

성능 테스트 결과: DeepSeek-GRM-27B, 340B 파라미터 거대 모델과 동등한 성능 입증

연구팀은 Reward Bench, PPE, RMB, ReaLMistake 등 다양한 RM 벤치마크에서 여러 방법의 성능을 평가했다. 각 벤치마크에 대해 표준 평가 지표를 사용했다: Reward Bench, PPE, RMB에서는 응답 세트에서 최선의 응답을 선택하는 정확도, ReaLMistake에서는 ROC-AUC 등이다.

기본 메소드로는 LLM-as-a-Judge, DeepSeek-BTRM-27B, CLoud-Gemma-2-27B, DeepSeek-PairRM-27B를 재구현했다. 실험 결과, DeepSeek-GRM-27B가 기본 메소드보다 전체 성능이 뛰어나며, Nemotron-4-340B-Reward와 GPT-4o 같은 강력한 공개 RM과 비슷한 성능을 보였다. 추론 시간 확장을 통해 DeepSeek-GRM-27B는 더욱 향상되어 최고의 전체 결과를 달성했다.

스칼라 및 세미 스칼라 RM은 다른 벤치마크보다 검증 가능한 작업(PPE Correctness)에서 유의미하게 더 나은 성능을 보이는 등 편향된 결과를 보여주었다. 대부분의 공개 스칼라 RM도 심각한 도메인 편향을 보였다. LLM-as-a-Judge는 DeepSeek-GRM-27B와 유사한 경향을 보였지만 성능이 낮았는데, 이는 원칙 가이드가 부족한 때문일 수 있다. 결론적으로 SPCT는 스칼라 및 세미 스칼라 RM에 비해 편향이 훨씬 적은 GRM의 일반적인 보상 생성 능력을 향상시킨다.

FAQ

Q: 생성형 보상 모델(GRM)이 기존의 스칼라 보상 모델과 어떤 차이점이 있나요?

A: 생성형 보상 모델(GRM)은 단순히 숫자 값을 출력하는 스칼라 모델과 달리 텍스트 형태의 원칙과 비평을 생성합니다. 이를 통해 다양한 입력 유형에 대한 유연성을 제공하고, 같은 응답에 대해서도 다양한 보상 신호를 생성할 수 있어 추론 시간 확장을 통한 성능 향상이 가능합니다.

Q: 자가 원칙 비평 조정(SPCT)의 핵심 아이디어는 무엇인가요?

A: SPCT의 핵심은 GRM이 쿼리와 응답에 기반하여 적응적으로 원칙을 생성하고, 이러한 원칙에 따라 정확한 비평을 생성하도록 학습시키는 것입니다. 이는 거부형 파인 튜닝과 규칙 기반 온라인 강화학습을 통해 이루어지며, 결과적으로 모델이 다양한 도메인에서 편향 없이 고품질 보상을 생성할 수 있게 합니다.

Q: 추론 시간 확장이 어떻게 대화형 AI의 성능을 향상시키나요?

A: 추론 시간 확장은 병렬 샘플링을 통해 여러 원칙과 비평 세트를 생성하고, 이를 통합하여 더 정확한 보상을 도출하는 과정입니다. 이는 단일 샘플링보다 더 다양한 관점에서 응답을 평가할 수 있게 하며, 메타 RM을 통해 낮은 품질의 샘플을 걸러내 최종 보상의 정확도를 높입니다. 결과적으로 대화형 AI는 사용자의 다양한 질문에 더 정확하고 적절한 응답을 제공할 수 있게 됩니다.

해당 기사에서 인용한 논문은 링크에서 확인할 수 있다.

이미지 출처: 딥시크

기사는 클로드와 챗gpt를 활용해 작성되었습니다.

AI Matters 뉴스레터 구독하기