Implementing responsible AI in the generative age

‘책임 있는 AI’ 원칙, 기업 경쟁력의 핵심 요소로 자리매김

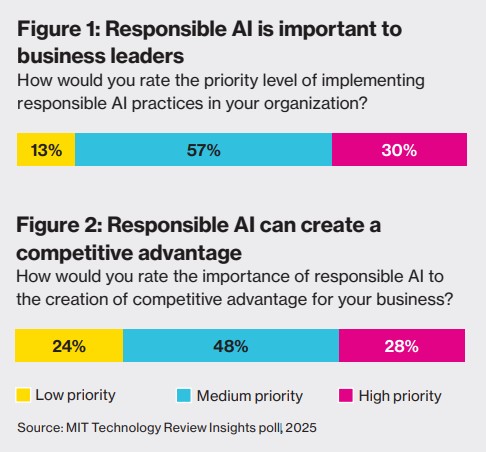

MIT 테크놀로지 리뷰 인사이트(MIT Technology Review Insights)가 250명의 비즈니스 리더를 대상으로 실시한 설문조사에 따르면, 응답자의 87%가 책임 있는 AI(Responsible AI) 원칙을 도입하는 것이 자사에서 높거나 중간 수준의 우선순위라고 답했다. 또한 76%는 책임 있는 AI가 경쟁 우위를 확보하는 데 있어 높거나 중간 수준의 우선순위라고 응답했다.

AI, 특히 생성형 AI는 이제 개념 증명 단계를 넘어 폭넓은 도입 단계로 접어들었다. 고객 서비스나 소프트웨어 개발과 같은 영역에 이 기술을 적용하면 전체 프로세스와 기능을 혁신할 수 있는 잠재력이 있다. ISG 리서치(ISG Research)의 추정에 따르면, 생성형 AI는 통찰력을 자동화하고 강력하고 오류에 강한 코딩 관행을 촉진하며 소프트웨어 품질과 보안을 향상시키면서 소프트웨어 개발에서 약 30~42%의 생산성 향상을 제공한다.

책임 있는 AI 중요성 인식 87%, 실제 준비 완료는 15%에 불과... 사용자 수용 관리가 최대 난관

설문 조사에 따르면 응답자의 87%가 책임 있는 AI 원칙이 중요하다고 생각하지만, 실제로 이를 효과적으로 구현할 준비가 되어 있다고 느끼는 응답자는 15%에 불과했다. 또한 기업들은 AI 관련 위험 요소에 대처하는 능력에 자신감이 부족한 것으로 나타났다.

응답자들의 58%만이 데이터 프라이버시 및 보안 위반에 대처할 수 있는 높은 능력을 갖추고 있다고 답했으며, 운영 중단에 대처할 수 있는 능력을 갖췄다고 답한 응답자는 50%였다. 규제 프레임워크 준수 능력에 대해서는 34%만이 높은 능력을 갖추고 있다고 응답했으며, 편향성과 공정성 문제에 대처할 수 있는 능력을 갖췄다고 답한 응답자는 26%에 불과했다. 가장 낮은 자신감을 보인 영역은 사용자 수용과 변화 관리로, 단 23%만이 이 영역에서 높은 능력을 갖추고 있다고 답했다.

책임 있는 AI 구현을 위한 5단계

생성형 AI 시대에 책임 있는 AI를 실제로 구현하기 위해서는 선도적인 기업들이 채택하고 있는 일련의 모범 사례가 필요하다. 이러한 사례에는 AI 모델과 데이터의 카탈로그화 및 거버넌스 제어 구현이 포함될 수 있다. 기업들은 위험, 보안 및 규제 준수를 위한 엄격한 평가, 테스트 및 감사를 수행하는 것이 유익할 수 있다. 동시에 직원들에게 대규모 교육을 제공하고 궁극적으로 책임 있는 AI를 리더십 우선순위로 만들어 변화 노력이 지속되도록 해야 한다.

아푸르브 아이어에 따르면 조직은 다음과 같은 5단계를 거쳐 책임 있는 AI를 효과적이고 지속 가능하게 통합한다:

- 기초 정책 수립: 모든 조직은 잘 정의된 정책과 책임 있는 AI에 대한 지침 원칙으로 시작해야 한다. 이러한 기초 정책은 조직의 윤리적 기준과 운영상의 요구에 부합해야 한다.

- 주요 이해관계자 파악: 성공적인 책임 있는 AI 구현을 위해서는 기술, IT, 비즈니스, 법률, 리스크 및 컴플라이언스 등 다양한 부서의 참여가 필요하다. 이러한 이해관계자들은 책임 있는 AI 사무소에 대표되어야 하며 조직 내에서 책임 있는 AI의 챔피언 역할을 해야 한다.

- 책임 있는 AI 아키텍처 개발: 효과적인 IT 아키텍처는 기본 원칙과 도구를 포함하며, 신뢰할 수 있는 파트너십의 역량을 활용할 수 있다. 이 아키텍처는 조직 전체에 책임 있는 AI를 구현하고 확장하기 위한 중추 역할을 한다.

- 사용자 수용과 허용 가능한 사용 장려: 사용자 교육, 허용 가능한 사용 정책, 변화 관리 프로세스는 대규모로 책임 있는 AI 수용을 보장하는 데 중요하다. 적절한 교육은 직원, 사용자 및 파트너가 AI 사용 지침을 이해하고 준수하도록 돕는다.

- 개선과 지속적인 향상 추구: AI 시스템은 사용자 피드백, 사고 및 진화하는 AI 발전에 기반한 지속적인 개선이 필요하다. 피드백 루프를 구축하면 조직이 새로운 과제에 대응하고 책임 있는 AI 관행을 개선하는 데 도움이 된다.

신뢰 잃으면 재구축에 오랜 시간 소요...산업별 AI 채택 속도 달라져야

HCL테크의 최고 기술 책임자이자 에코시스템 책임자인 비제이 군투르(Vijay Guntur)는 "신뢰를 잃으면 재구축하는 데 오랜 시간이 걸릴 것"이라며 AI에 대한 신뢰의 중요성을 강조했다. 특히 금융 서비스나 의료와 같이 고도로 규제된 산업에서는 위험이 더 크다. 이러한 산업은 과거보다 훨씬 더 책임 있는 AI 표준에 주의를 기울여야 할 것이다. "특정 산업들은 훨씬 더 빠르게 책임 있는 AI를 채택해야 할 것입니다. 기업 내 기능 간의 수평적 채택을 넘어 AI의 산업적 관점을 취하면 위험에 대한 허용치가 변화합니다"라고 군투르는 설명했다.

궁극적으로 리더들은 명확한 기대치를 표현하고 기능, 부서 및 비즈니스 단위 전반에 걸쳐 책임감 있는 사용을 보장하기 위해 AI 프로젝트에 대한 윤리적 지침을 제공해야 한다. 책임 있는 AI를 잘 구현하면 이득이 된다. 리더들에게 조직의 가장 귀중한 자산인 신뢰를 보호하는 데 있어 적절한 균형을 유지하고 있다는 확신을 준다.

"리더들은 생산성 향상이든 새로운 비즈니스 프로세스와 서비스의 발견이든 AI로 경쟁 우위를 확보하길 원합니다. 그러나 동시에 규제 또는 비규제 환경에서 관리를 확실히 하기 위해 AI를 사용하길 원합니다. 따라서 균형이 있어야 합니다"라고 홀은 결론을 내렸다.

FAQ

Q: 책임 있는 AI란 정확히 무엇인가요?

A: 책임 있는 AI는 AI 시스템이 공정하고, 투명하며, 사회에 유익해야 한다는 개념입니다. 미국 국립표준기술연구소(NIST)에 따르면 AI 신뢰성의 필수 요소에는 유효성과 신뢰성, 안전성, 보안 및 복원력, 책임 및 투명성, 설명 가능성 및 해석 가능성, 개인정보 보호, 유해한 편향 완화와 함께하는 공정성이 포함됩니다.

Q: 생성형 AI가 기업에 어떤 혜택을 제공하나요?

A: 생성형 AI는 소프트웨어 개발에서 약 30~42%의 생산성 향상을 제공할 수 있습니다. 이는 통찰력을 자동화하고, 강력하고 오류에 강한 코딩 관행을 촉진하며, 소프트웨어 품질과 보안을 향상시킵니다. 또한 고객 서비스, 마케팅 등 다양한 업무 영역에서 프로세스를 혁신할 수 있습니다.

Q: 기업이 책임 있는 AI를 구현할 때 가장 어려워하는 부분은 무엇인가요?

A: 설문 조사에 따르면 기업들이 가장 어려워하는 영역은 사용자 수용과 변화 관리(응답자의 23%만이 높은 능력을 갖추고 있다고 응답), 편향성과 공정성 문제(26%), 규제 프레임워크 준수(34%)입니다. 반면, 데이터 프라이버시 및 보안(58%)과 운영 중단(50%) 관리에는 상대적으로 더 높은 자신감을 보였습니다.

해당 기사에서 인용한 리포트 원문은 링크에서 확인할 수 있다.

기사는 클로드와 챗GPT를 활용해 작성되었습니다.

AI Matters 뉴스레터 구독하기

![리얼 8000Hz 응답속도! 게임 성능에 감성 한 스푼♥ 한성 TFG Cloud Max CF 키보드 리뷰 [프리미엄 리포터V]](https://img.danawa.com/images/attachFiles/6/971/5970432_1.jpeg?shrink=320:180)

![[네이버] 드라이 기모 후드 티셔츠 빅사이즈 12,000원 배송비 3,000원](https://img.danawa.com/images/attachFiles/6/971/5970261_1.png?fitting=Large|140:105&crop=140:105;*,*)

![[포인트 마켓] 한정판! 2026 다나와 굿즈 보온보냉백 1개](http://img.danawa.com/shop_img/dasale/goods/494/026/26494_70.jpg?fitting=Large|140:105&crop=140:105;*,*)